ALBERT: 自己監督学習による言語表現のための軽量 BERT

ALBERT は自然言語処理(NLP)の分野において画期的な存在です。BERT の登場以降、大量の既存テキストを利用して自己監督学習によりモデルのパラメータを事前学習する新たなパラダイムが確立されました。ALBERT はこのアプローチを発展させ、12 の NLP タスクで最先端の性能を達成しています。

入力レベルの埋め込みと隠れ層の埋め込み 入力レベルの埋め込みは単語やサブトークンなどのコンテキスト非依存的な表現を学習します。一方、隠れ層の埋め込みはそれをコンテキスト依存的な表現に精製します。ALBERT では、埋め込みパラメータ化の因数分解により、この効率的なモデル容量の割り当てが実現されています。

層間のパラメータ共有 Transformer ベースのニューラルネットワークアーキテクチャでは、独立した層が積み重なっていますが、ALBERT では層間のパラメータ共有により冗長性を排除しています。

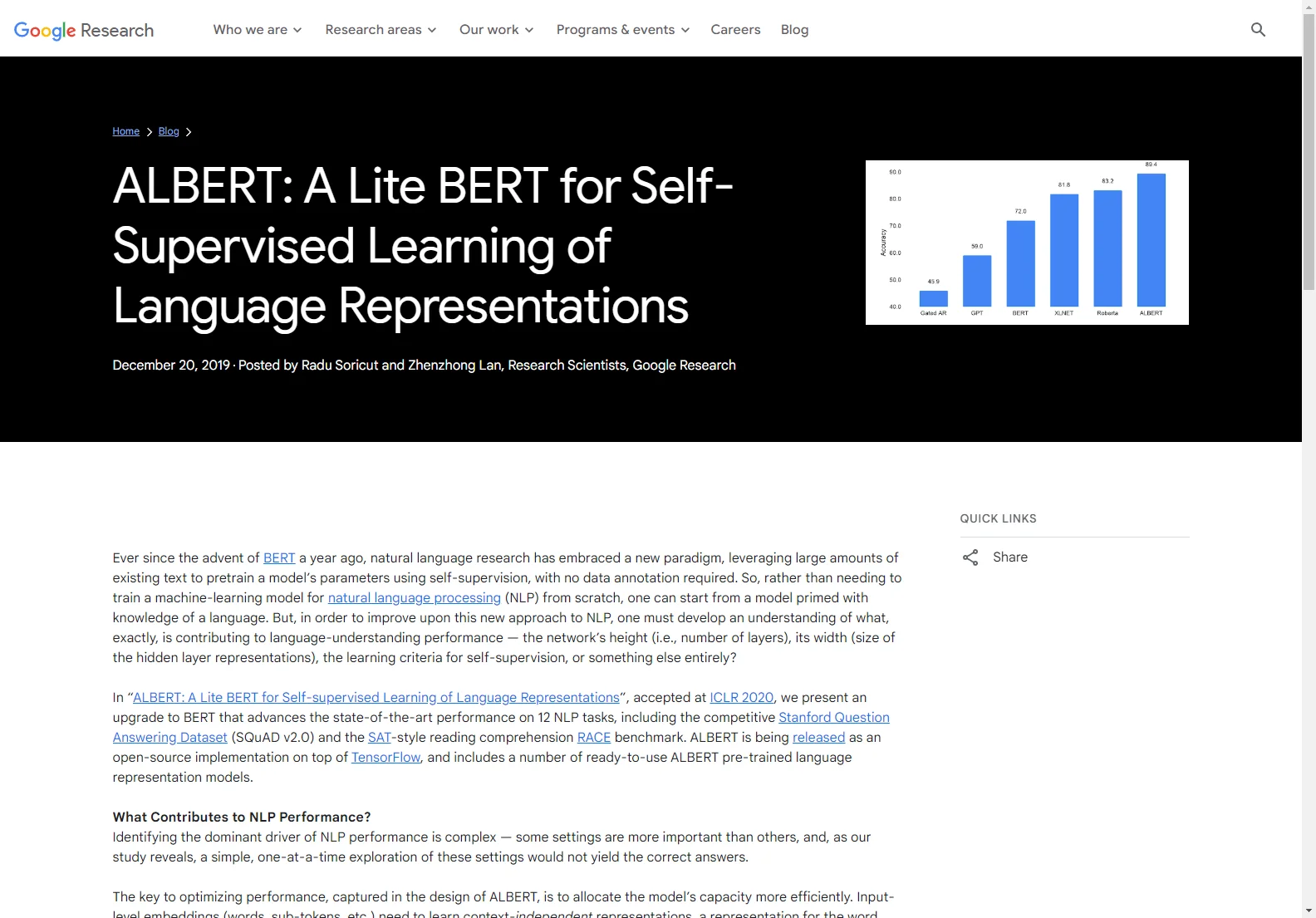

RACE データセットによるモデル性能の最適化 RACE データセットを用いてモデルの言語理解能力を評価できます。ALBERT はこのデータセットでも高い性能を発揮しており、XLNet や RoBERTa と同じ大きなデータセットで訓練すると、これまでの手法を上回る成果を出しています。

ALBERT の成功は、モデルの強力なコンテキスト表現を生み出す側面を特定することの重要性を示しています。